Merci @PHB_fr pour tes compliments

En effet, à composants informatiques égaux, les logiciels fonctionnant de façon dédiée sur le matériels en direct sera toujours plus performants. Il n’y a pas toutes les surcouches (que ce soit containerd, lxc; les couches de virtualisations; etc)

Mais toutes choses est relative. Perso j’ai un Rog 8 coeurs 32Gb DDR4 intel I7 et du ssd pour mon serveur de virtualisation. Avec 4 vCPU et 4Gb de RAM alouée pour Jeedom, ca tourne bien mieux que sur un Raspi 4, un Odroid C2 en direct. Je parle même pas d’un Synology genre DS214se

Ca dépend des ressources à sa disposition. C’est toute la difficulté en architecture de solution :

1°) Comprendre les besoins. Le plus dur c’est comprendre ses propres besoins. Ce n’est pas si simple qu’on le crois.

2°) Comprendre les contraintes et les risques

3°) Prendre en considération les aspects de maintenabilité et dévolution à court, moyen, long terme

4°) Adapter sa solution en fonction des tous les paramètres importants.

et surtout surtout surtout; le plus important : TESTER, EVALUER, MESURER, et se remettre en question afin de s’adapter au besoin.

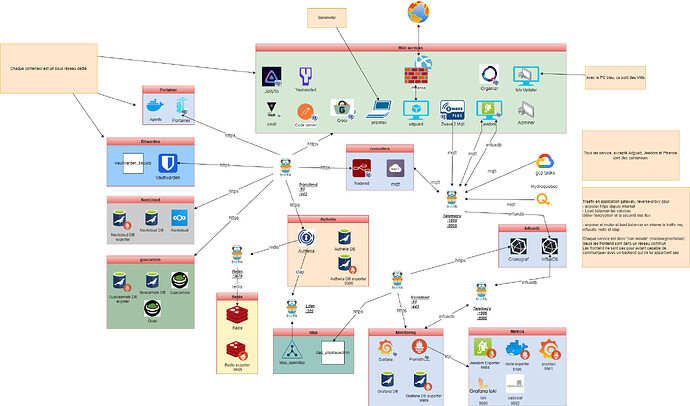

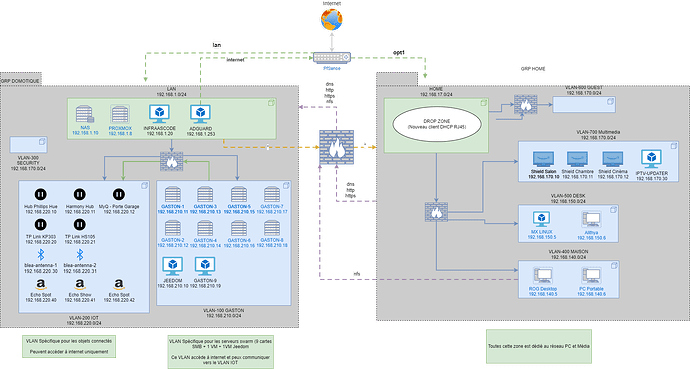

Pour cette raison, dans mon cas, j’ai analysé les + et le - de docker (Swarm et Kubernetes) vs VM vs Bare-metal. Et la solution qui ME convient le mieux par rapport à MES besoins, mes attentes et mes ressources c’est la VMs. Ca peux être différents pour d’autres. Il faut l’accepter

Après, comme c’est mon domaine professionnel, je vois tout cela de part ma vision et mon expérience métier.

Autre aspect intéressant que tu apportes @PHB_fr, Beaucoup de personne vont avoir une expérience accompagnée d’un biais cognitif par rapport à leur récent achat, etc. : 'Je viens d’acheter ce NAS dernier cri, j’ai tester avec Docker et c’est mieux que tout avant". A cela je dirais ceci :

Dans le monde professionnel, même sur des équipements très haut niveau pour des NAS, on ne fera JAMAIS tourner des VMs et des conteneurs dessus (Ou alors l’architecture qui a conçu cela devrait changer de boulot). Cela va avoir un impact majeur sur l’IOPS. Or ce que l’on demande à un NAS c’est d’envoyer du débit sur le stockage. On aura des serveur dédiés pour l’hébergement des services. C’est pour cela que je reste mitiger sur l’utilisation d’un NAS « ayant un OS permetttant » la contenérisation ou la virtualisation. Pour le grand public et de façon modéré, ca peux encore aller. Mais si vous avez un serveur de média (Jellyfin, Plex, Emby par exemple) cela va avoir un impact sur les transferts de flux et dégrader les performances au niveau du NAS lui même.

Je dirais donc que c’est bien pour 2/3 services n’ayant pas besoin d’avoir de grosses perf. Sinon, utilisez un serveur dédié.

Pour finir ce message voici ce que je dirais pour le personne qui se demande vers quelle solution se tourner :

- Essayer la VM, Docker et en bare metal pendant 1 temps (2/3mois). Voyez ce qui vous conviens le mieux pour VOUS et puis foncer.

EDIT : Détail qui a son importance également.

L’une des raisons qui m’a également poussé à ce type d’architecture est également la sécurité autour de l’IOT. Les objets connectés peuvent être une faille de sécurité dans un réseau domotique. Aussi, une hackers peut facilement trouver une faille dans Amazon Echo, Google, etc. voir dans des équipements dédiés (pont domotique, etc.). Aussi, afin de sécuriser tous mes PCs persos, bureau, mes serveurs, etc. mon réseaux personnels est composé de 2 LANs et 8 VLANs dont 1 pour l’IOT. Vous l’aurez compris, tous les équipements ont leurs propres VLAN et des règles de pare-feu pour permette à la stacks domotique d’interroger les équipements, mais les équipements ne peuvent pas communiquer en direct avec la stack domotique (diode logique).

Voici un vieux schéma (pas à jour) qui montre un peu le principe pour les personnes intéressées

.